Notice

Recent Posts

Recent Comments

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 | 31 |

Tags

- 퀀트

- Python

- WTI유

- 테슬라

- WTI

- 스크리닝

- 기업분석

- 머신러닝

- 아모레퍼시픽

- 중국경제

- 주가분석

- FOMC

- 엘론 머스크

- DSP

- 중국증시

- 경제위기

- 미국금리

- 반려견치매

- 넬로넴다즈

- 주식투자

- 국제유가

- 코로나19

- 마법공식

- 뉴지스탁

- prometheus

- 유상증자

- 지엔티파마

- 금리인상

- 뇌졸중

- 제다큐어

Archives

- Today

- Total

Data Analysis for Investment & Control

ReLU(Rectified Linear Unit) 본문

반응형

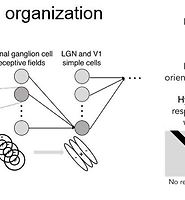

CNN의 발전 과정에 있으면서 Deep Neural Network의 Weight Update의 Vanishing/Exploding 이슈를 해결할 목적으로 도입된 Activation Function의 한 종류이다.

Sigmoid나 Hyperbolic Tangent와 달리 |x| 가 큰 값일 경우에 미분 값이 0으로 수렴하는 단점이 없고 수식 구현이 간단하기 때문에 많이 사용된다.

수식은 다음과 같으며,

위의 함수를 그래프로 표시하면 아래와 같다.

Geoffrey E. Hinton 교수에 의해 제안되었다고 알려져 있으며 다음은 그 내용이 수록된 논문이다.

Rectified linear units improve restricted boltzmann machines.pdf

Rectified linear units improve restricted boltzmann machines.pdf

반응형

'MachineLearning > Classification' 카테고리의 다른 글

| RNN, Recurrent Neural Network과 LSTM (0) | 2018.08.28 |

|---|---|

| CNN, Convolution Neural Network (가이드) (0) | 2018.08.28 |

Comments